Обновлено в июле 2014

Отказоустойчивый кластер

Два сервера и система хранения данных — это минимальный набор для построения отказоустойчивого кластера с использованием технологий серверной виртуализации. Отказоустойчивость будет обеспечиваться на аппаратном уровне, т.е. выход из строя оборудования не приведет к остановке работы.

Я попробую рассмотреть все возможные варианты подключения серверов и СХД нижнего ценового сегмента и сравнить их между собой. Оборудование, которое я буду использовать в расчетах производства IBM.

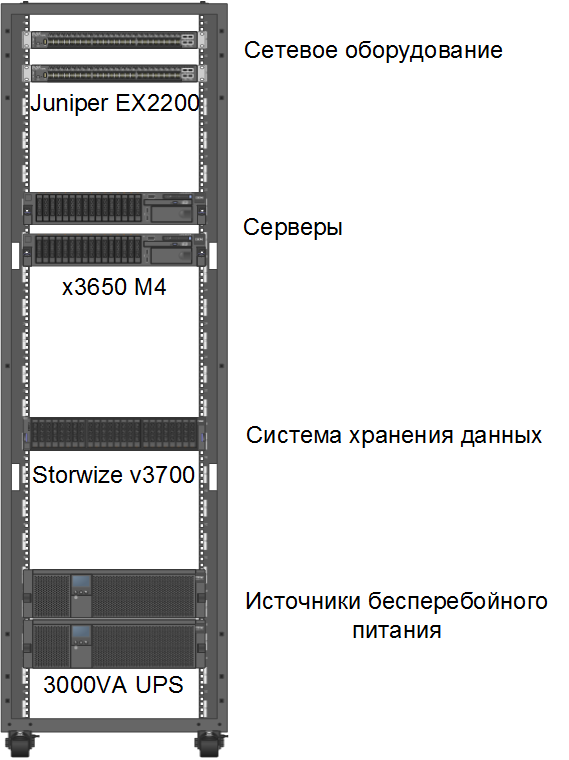

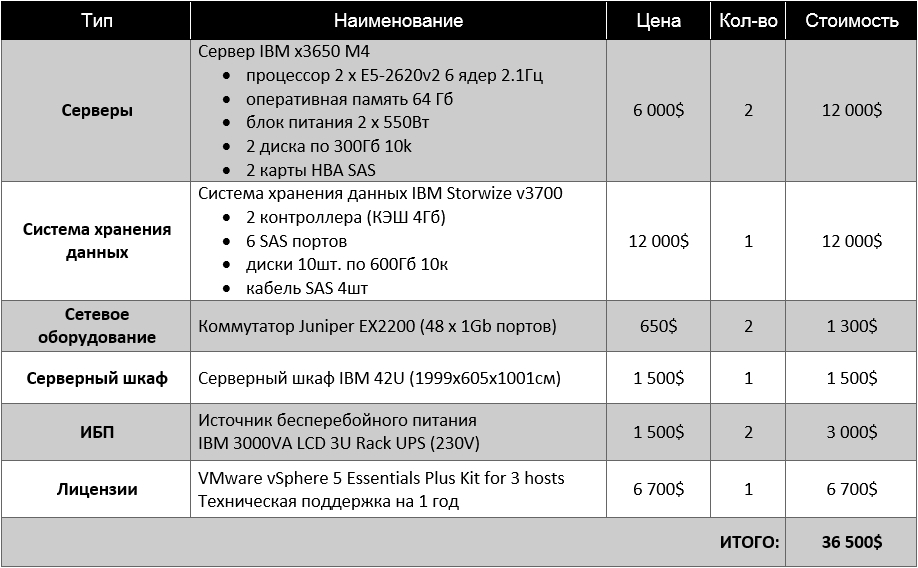

Проект будет складываться из следующих элементов:

- Серверы x86 архитектуры, IBM x3650 M4 (описание)

- Система хранения данных IBM Storwize v3700 (описание)

- Лицензии на платформу виртуализации, лицензии Microsoft Windows

- Сетевое оборудование

- Серверный шкаф, источники бесперебойного питания, PDU (описание)

Физическая архитектура решения

Питание. В каждом сервере 2 блока независимых питания, которые будут подключены к разным источникам бесперебойного питания. Тоже самое и с системой хранения данных. Соединение можно производить напрямую, либо через блоки розеток.

Подключение СХД к серверам.

Связать систему хранения и серверы можно двумя бюджетными способами:

- iSCSI 1Gbe — система хранения подключается к коммутаторам, серверы тоже подключаются к коммутаторам. В СХД используются по два сетевых порта в каждом контроллере, в серверах тоже используются по два сетевых порта. Прямое подключение не поддерживается

- прямое подключение по SAS — в серверы докупаются две дополнительные одно портовые карты расширения SAS HBA. Они через соединительные SAS кабели коммутируются с существующими портами в системе хранения данных Прямое подключение поддерживается.

Есть также не бюджетные способы, которые потребуют значительных дополнительных расходов:

- Fibre Channel (FC) — чтобы связать серверы и СХД оптическими каналами нужно будет докупить в систему хранения дополнительную карту и дополнительные FC HBA контроллеры в каждый сервер. Прямое подключение поддерживается.

- 10 Gb iSCSI/Fibre Channel over Ethernet (FCoE) — в данном случае также докупаются дополнительные карты в систему хранения и дополнительные 10 Gbe HBA контроллеры в каждый сервер. Дополнительно потребуются десятигигабитные оптические коммутаторы, т.к. в данном случае прямое подключение не поддерживается. Такое подключение в данном решении нецелесообразно, поэтому рассматриваться в таблице ниже не будет.