3D VDI

В статье про VDI была подробно описана технология перевода обычных офисных пользователей со стационарных компьютеров в среду виртуальных рабочих станций. Но VDI подходит не только для офисных сценариев работы, а и для тех, где используются ресурсы профессиональных GPU видеокарт. В этой статье описываются существующие технологии аппаратного ускорения графики в виртуальных рабочих столах VMware Horizon c использованием технологии Nvidia GRID. Также будут рассмотрены распространенные варианты использования 3D VDI и подходящие для этих случаев технологии графического ускорения.

В статье про VDI была подробно описана технология перевода обычных офисных пользователей со стационарных компьютеров в среду виртуальных рабочих станций. Но VDI подходит не только для офисных сценариев работы, а и для тех, где используются ресурсы профессиональных GPU видеокарт. В этой статье описываются существующие технологии аппаратного ускорения графики в виртуальных рабочих столах VMware Horizon c использованием технологии Nvidia GRID. Также будут рассмотрены распространенные варианты использования 3D VDI и подходящие для этих случаев технологии графического ускорения.

Специалисты, активно использующие в своей работе ресурсы видеокарты, работают за мощными профессиональными рабочими станциями. Архитекторы, дизайнеры, учёные, инженеры физически привязаны к своим рабочим ПК, что в 2020 году стало проблемой для работодателей. Пандемия показала, насколько важно отвечать требованиям времени, причем технологии для этого на рынке существуют уже давно. Возможность перевода ключевых сотрудников на удаленный режим работы, позволяет не останавливать рабочий процесс и сохранить бизнес.

Для решения задачи доступа пользователей к виртуальным рабочим станциям VDI с любого доступного пользователю оборудования, необходимо переместить вычислительные мощности с рабочих мест в ЦОД. Затем можно подключаться к VDI по локальной сети из офиса или за пределами офиса через интернет. Для подключения можно использовать недорогой ПК, ноутбук, смартфон, планшет или специальный тонкий клиент. Спецификой 3D VDI является то, что необходимо в каждую виртуальную машину дополнительно доставить ресурсы GPU. Для этого в сервер, где запущены виртуальные машины, устанавливается совместимая видеокарта(ы), ресурсы которой делятся между пользователями VDI на конкурентной основе.

Запись на тестирование

Первое знакомство с технологией можно провести через тест-драйв от Nvidia. Но на его основании невозможно сделать осознанный выбор, т.к. тестировать нужно на ваших программах, на ваших пользователях и без ограничений по времени.

Если у вас есть потребность в организации тестирования просьба заполнить форму обратной связи. К тестированию принимаются заявки только от юридических лиц, также большая просьба из-за праздного интереса не беспокоить.

Чтобы дать возможность пользователю удаленно подключиться к виртуальной машине и работать с приложениями, использующими ресурсы видеокарты, одной технологии Nvidia GRID недостаточно. Для решения задачи используется комплекс решений от разных производителей, как программных, так и аппаратных. Сама компания Nvidia выпускает видеокарты, поддерживающие технологию GRID, разрабатывает драйверы для гипервизоров и гостевых ОС.

Разделение ресурсов GPU

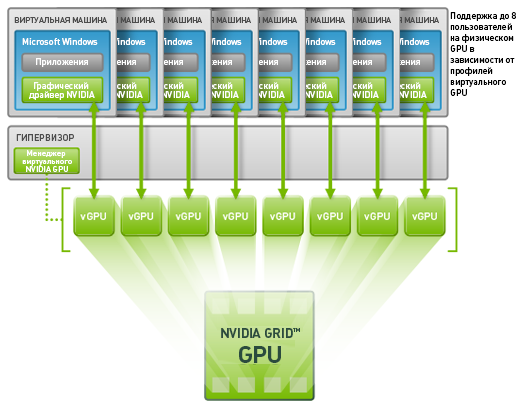

Nvidia GRID – это название технологии, которая позволяет распределять графические ресурсы видеокарт между виртуальными машинами. Главным образом, это требуется для организации защищенного удаленного доступа в центральный офис для конструкторов, проектировщиков, дизайнеров для совместной работы над проектами. В этом случае, сами проекты (файлы) не покидают пределов серверной (ЦОД), дорогостоящие лицензии на САПР не нужно передавать сотрудникам, рабочее место сотрудника, который должен будет работать с тяжелой графикой, можно заменить на обычный компьютер, ноутбук или тонкий клиент. Сам сотрудник может работать как из офиса, так и из дома, командировки, другого города.

Nvidia GRID – это название технологии, которая позволяет распределять графические ресурсы видеокарт между виртуальными машинами. Главным образом, это требуется для организации защищенного удаленного доступа в центральный офис для конструкторов, проектировщиков, дизайнеров для совместной работы над проектами. В этом случае, сами проекты (файлы) не покидают пределов серверной (ЦОД), дорогостоящие лицензии на САПР не нужно передавать сотрудникам, рабочее место сотрудника, который должен будет работать с тяжелой графикой, можно заменить на обычный компьютер, ноутбук или тонкий клиент. Сам сотрудник может работать как из офиса, так и из дома, командировки, другого города.

Для реализации проекта удаленного доступа с использованием технологии Nvidia GRID требуется подбор, покупка и настройка программно-аппаратного комплекса. На стадии подбора необходимо провести ряд нагрузочных тестов для получения ответов на три основных вопроса. Первый принципиальный, подходит ли технология Nvidia GRID для решения ваших задач? Второй, какой максимальной плотности ваших пользователей на 1 сервер можно добиться в условиях повседневной эксплуатации? Третий, какой состав оборудования, лицензий и работ необходимы для внедрения проекта?

Рассмотрим, какие вообще существуют способы получить в удаленном сеансе подключения к виртуальной машине возможность для работы с графикой. Ведь по-умолчанию, в ВМ присутствует виртуальная видеокарта, которая использует для работы ресурсы центрального процессора (CPU) и оперативную память.

1. Nvidia vGPU

Nvidia vGPU. Самая передовая на сегодняшний день технология разделения ресурсов физической видеокарты между виртуальными машинами реализована в гипервизоре VMware ESXi 6 и Citrix XenServer 6.5. Настройка проброса видеокарты в виртуальную машину состоит из следующих основных шагов:

Настройка проброса видеокарты в виртуальную машину состоит из следующих основных шагов:

- В сертифицированный сервер устанавливаются видеокарты Nvidia GRID K1, K2 или Nvidia Tesla M60, M6 (M6 — карта для блейд серверов). Для выбора сервера рекомендуется использовать лист совместимости на сайте Nvidia.

- На сервер инсталлируется гипервизор VMware ESXi или XenServer.

- В гипервизор, через командную строку устанавливается Nvidia GPU Software. После этого в гипервизоре активируется функционал GRID.

- На гипервизоре создается виртуальная машина Windows или Linux. В свойствах виртуальной машины появляется возможность добавить один из профилей видеокарты Nvidia.

- В гостевую операционную систему Window или Linux необходимо установить драйвер от Nvidia, чтобы видеокарта начала работать.

*Карты Tesla M60 и M6 «из коробки» работают в режиме расчета (Compute), для активации режима работы vGPU (Graphics) необходимо выполнить действия описанные в инструкции

** Карты Tesla M60 и M6 относятся к поколению GRID 2.0, в котором для работы функционала требуется настройка сервера лицензий и покупка соответствующих лицензий. После установки драйвера в гостевую операционную систему, требуется в его настройках указать FQDN имя сервера лицензий. Только после этого видеокарта будет полноценно работать.

*** Для карт GRID K1 и K2 покупка лицензий, переключение режима работы не требуется

Профиль vGPU

Гипервизор делит доступные ему ресурсы видеокарт Grid K1,K2 или Tesla M60, M6 на профили vGPU, которые отличаются друг от друга рядом характеристик:

- объем видеопамяти, — каждому профилю vGPU соответствует фиксированный объем видеопамяти, который резервируется на физической видеокарте. Отсюда всегда в уме можно посчитать, на какое количество виртуальных машин можно разделить, например, видеокарту Tesla M60, которая несет на борту 16Gb видеопамяти. На 16 vGPU по 1GB видеопамяти, или на 8 vGPU с 2Gb видеопамяти и т.д.

- поддерживаемые ОС, — всегда поддерживается Windows гостевая операционная система, в более продвинутых профилях еще и Linux. Поддержка vGPU в Linix появилась только в GRID 2.0

- максимальное число дисплеев

- максимальное разрешения дисплея

- возможности программного обеспечения NVIDIA® Quadro

- поддержка CUDA, OpenGL, GPU Pass-throught — дело в том, что в картах Nvidia GRID всегда несколько графических чипов. Если этот чип используется несколькими vGPU профилями на конкурентной основе, то невозможно использовать профессиональные технологии (CUDA, OpenGL). Чтобы задействовать их, нужно отдавать весь чип видеокарты в виртуальную машину. Это значительно уменьшает плотность пользователей на сервер, но позволяет добиться высокой производительности с продвинутыми фичами.

Ниже таблица со списком vGPU профилей для Nvidia GRID K1 и K2, которые относятся к первому поколению GRID технологии. Для определения набора технологий доступных в GRID 2.0 лучше всего пользоваться официальным сайтом.

2.Прямой проброс (vDGA, Pass-throught)

Прямой проброс. Преимущество данного подхода в том, что при использовании сервера с картами GRID K1 и K2 , пробросив графические чипы карты напрямую в виртуальную становится доступна технология CUDA от Nvidia, которая не работает в режиме vGPU. Принцип работы, — на сервере или мощной рабочей станции установлен гипервизор и созданы виртуальные машины куда в режиме 1 к 1 проброшены видеочипы физических видеокарт. Например, у Nvidia Grid K1 четыре физических ядра, у K2 два, а у недорогих видеокарт обычно одно ядро. Соответственно чем больше физических GPU вы сможете уместить в сервере, тем больше виртуальных машин можно будет обеспечить видеокартами по технологии прямого проброса.

Прямой проброс. Преимущество данного подхода в том, что при использовании сервера с картами GRID K1 и K2 , пробросив графические чипы карты напрямую в виртуальную становится доступна технология CUDA от Nvidia, которая не работает в режиме vGPU. Принцип работы, — на сервере или мощной рабочей станции установлен гипервизор и созданы виртуальные машины куда в режиме 1 к 1 проброшены видеочипы физических видеокарт. Например, у Nvidia Grid K1 четыре физических ядра, у K2 два, а у недорогих видеокарт обычно одно ядро. Соответственно чем больше физических GPU вы сможете уместить в сервере, тем больше виртуальных машин можно будет обеспечить видеокартами по технологии прямого проброса.

Для XenServer это могут быть НЕ любые видеокарты, а только те, для которых производитель позаботился и выпустил драйверы для гипервизора. Тогда карта корректно определяет и дает возможность перенаправлять их в виртуальную машину. Сейчас Citrix XenServer поддерживает в режиме pass-through только видеокарты Nvidia и AMD (лист совместимости).

У VMware другой принцип проброса видеокарт. Специальные драйверы в гипервизор для работы режима прямого проброса ставить не нужно, устройство перенаправляется как PCI-E карта.

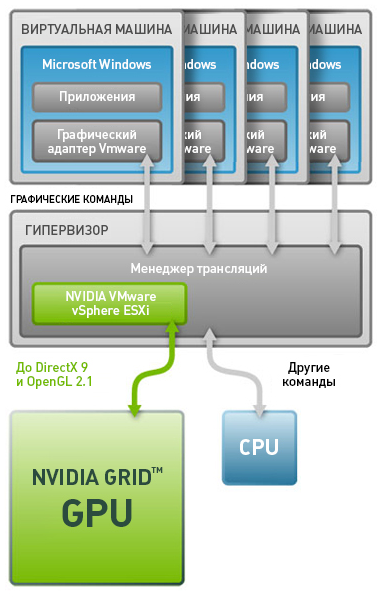

3. Программный шаринг (VMware vSGA)

Программный шаринг у VMware. Опять сервер или рабочая станция с видеокартой, установлен гипервизор, который эмулирует в виртуальной машине GPU. Работает это примерно так, получаем мы от Solidworks задачу отобразить деталь на экране, для этого ее нужно обсчитать, посылаются команды к виртуальной GPU, которые принимает гипервизор и передает физической видеокарте, получает от нее результат и возвращает его обратно через эмулируемую видеокарту в SW. Такой механизм работы, через посредника, в разы тормозит процесс, поэтому серьезные графические расчеты делать не получится.Чтобы работал режим программного шаринга необходимо установить драйвер в гипервизор. На сайте Nvidia можно свободно скачать драйвер для VMware ESXi 6 (ссылка), для Microsoft Server (чтобы работал RemoteFX) драйверы в свободном доступе.

3. Графика в терминальном сервере

Так как в статье рассматриваются способы получения в удаленной сессии ресурсов графического адаптера, то нельзя не упомянуть про возможности современного терминального сервера на базе Windows server 2012R2. Если с помощью технологи vGPU или технологии Pass-through пробросить видеокарту в виртуальную машину с настроенным терминальным сервером, установить в эту виртуальную машину драйверы видеокарты, то терминальные пользователи смогут на конкурентной основе использовать ресурсы видеокарты.

Такой способ больше подходит для офисных пользователей, ведь он не позволяет эффективно работать в серьезных САПР, но для просмотра чертежей, веб серфинга, работы в программах из MS Office 2013 подходит идеально. Естественно, плотность пользователей при такой архитектуре выше, чем в классическом терминальном доступе, из-за разгрузки центрального процессора. В программах можно смело включать поддержку Hardware Acceleration и они не будут тормозить.

4. Подключение к физическому компьютеру

Мы подключаемся к физической машине (без гипервизора) в которой установлена видеокарта. Если протокол, по которому мы подключаемся позволяет работать с графикой, то можно поместить такую машину в серверную комнату под замок и давать к ней доступ сотрудникам.

С выходом VMware Horizon 8 компания совершила рывок в технологиях VDI, дала администраторам набор современных инструментов для создания виртуальных рабочих мест. Если же рассматривать часть которая касается работы с графикой в VDI, использования технологий Nvidia GRID, то здесь тоже есть о чем рассказать.

Режимы использования GPU

Всего в VMware Horizon 8 есть три типа графического ускорения для виртуальных рабочих станций:

- vSGA, Virtual Shared Graphics Acceleration — в этом режиме в виртуальной машине пользователю доступна эмуляция видеокарты с драйвером VMware vSGA 3D. Эта виртуальная видеокарта имеет поддержку OpenGL и DirectX, может использоваться для ускорения работы офисных пользователей в режиме VDI или для запуска простых графических приложений. На хост ESXi устанавливается драйвер для физической видеокарты и всё взаимодействие виртуальной видеокарты с физической происходят через ESXi. На это тратятся ресурсы сервера, что может стать узким местом в этом сценарии использования. Для использования vSGA не нужно покупать дополнительные лицензии от производителя видеокарт.

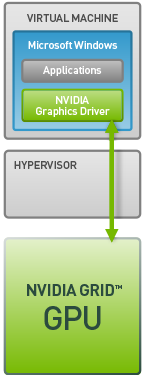

- vGPU, Virtual Shared Pass-Through Graphics Acceleration — в этом режиме виртуальная машина может работать с видеокартой в сервере напрямую, без использования ресурсов хоста ESXi. Физическая GPU может быть разделена на несколько виртуальных видеокарт vGPU. Для это на хост ESXi устанавливается VIB пакет с программным обеспечением от производителя GPU, через которое производится распределение vGPU между виртуальными машинами. При этом ядро (или ядра) видеокарты используется всеми виртуальными машинами на конкурентной основе, а часть видеопамяти физической GPU закрепляется за каждой vGPU(1,2,4,8 Gb). В виртуальной машине появляется vGPU для использования которой необходимо установить драйвер от Nvidia или AMD. Ресурсов vGPU достаточно для работы в требовательных к графическим ресурсам приложениях.

Для работы в режиме vGPU (Nvidia grid) необходима покупка дополнительных лицензий от Nvidia.

Список поддерживаемых видеокарт можно найти здесь. - vDGA, Virtual Dedicated Graphics Acceleration — это режим прямого проброса физической видеокарты в виртуальную машину. Позволяет использовать графический адаптер в одиночном режиме без деления с другими пользователями. Весь графический процессор и вся видеопамять доступны пользователю VDI. Список поддерживаемых карт здесь.

Нужно учесть, что Nvidia выпускает видеокарты, в которых может быть несколько GPU чипов.

Протоколы подключения VDI

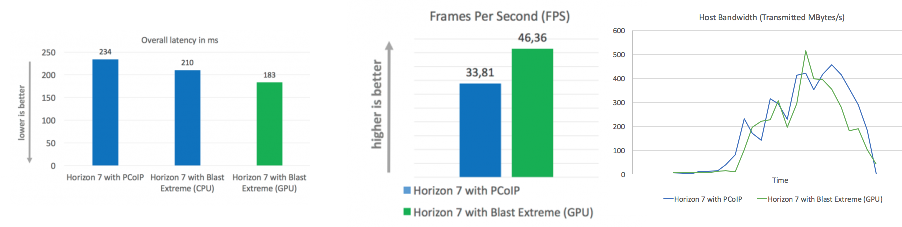

Вышел в релиз новый протокол подключения к виртуальным машинам VMware Blast Extreme. PCoIP никуда не делся, его тоже можно использовать, но для работы с графикой именно Blast Extreme подходит лучше всего.

Все дело в том, что Blast Extreme использует в своей работе технологию NVENC, позволяющую захватывать изображение экрана сразу в H.264 и без использования ресурсов CPU. В результате, в сравнении с PCoIP, уменьшаются задержки в доставке изображения на устройство клиента, уменьшается требование к пропускной способности канала подключения, увеличивается количество кадров в секунду (FPS).

Когда на сервере нет борьбы за ресурсы CPU, заметить плюсы от работы нового протокола VMware сложно, но можно открыв диспетчер задач и убедившись, что процесс Blast Extreme не грузит центральный процессор вообще. Использование NVENC — это реально прорыв, которого ждали с самого создания технологии GRID. При использовании PCoIP или Citrix HDX 3D Pro процесс захвата изображения мог использовать до 70-80% ядра процессора, если на это же ядро ложилась нагрузка от САПР приложения, то наблюдались неприятные задержки. Теперь с протоколом VMware Blast Extreme такое исключено.

У VMware также остается протокол PCoIP от компании Teradici. Протокол постоянно дорабатывается и оптимизируется и за этим интересно следить, подписавшись на рассылку на официальном сайте Teradici. Там же можно найти и другие интересные корпоративные решения, в которых технологии VMware никак не участвуют.

Принцип работы протокола PCoIP в его программном исполнении, а именно так его использует VMware, можно понять посмотрев небольшой ролик:

Принцип работы протокола PCoIP в его программном исполнении, а именно так его использует VMware, можно понять посмотрев небольшой ролик:

можно сделать некоторые выводы:

- в программном исполнении протокол PCoIP требует ускорения в двух случаях: если плотность пользователей высокая на хосте высокая и высока нагрузка на CPU и если приложения, запущенные в сессии VDI, используют в работе видеоадаптер

- для обычного, не графического VDI, можно использовать карту разгрузки APEX 2800, которая снимет часть нагрузки c центрального процессора и можно будет увеличить плотность пользователей.

- для графического VDI, где в сессии запускаются приложения, использующие GPU, лучше всего использовать смешанный вариант — и карта разгрузки APEX 2800 и видеокарта Nvidia GRID в режиме vGPU или vDGA

Все дело в протоколе

Все дело в протоколе

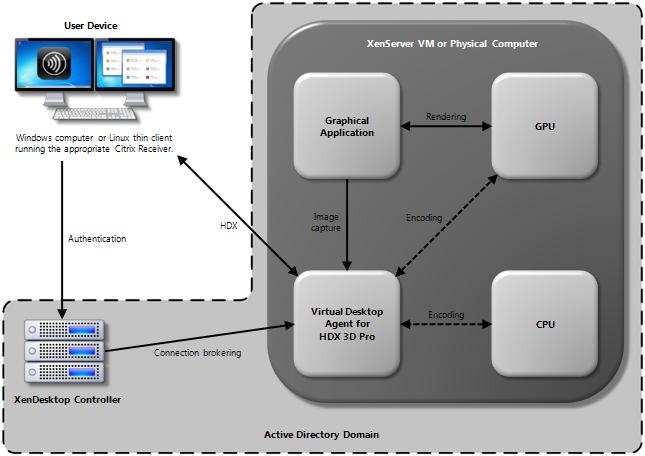

(HDX 3D PRO)

Разработка своего протокола для доставки изображения позволила компании Citrix выбиться в лидеры направления виртуализации графических рабочих станций. Уже в 2012 году внедрялись решения на базе Citrix XenDesktop 5.5 по переводу использующих CAD пользователей в VDI и это было время, когда Nvidia GRID существовала только на уровне идеи.

Принцип работы протокола HDX 3D pro выглядит следующим образом

- у нас должна быть виртуальная машина Windows 7+ с видеоадаптером, иначе использование протокола HDX 3D pro будет нецелесообразным. Раньше делали прямой проброс видеоадаптера в виртуальную машину средствами гипервизора или использовали физический компьютер, сейчас же технология Nvidia GRID позволяет без особых проблем обеспечить большое кол-во виртуальных машин виртуальными видеоадаптерами vGPU

- в эту машину устанавливается программа Citrix Virtual Desktop Agent для HDX 3D pro, которая умеет захватывать картинку экрана и передавать его на станцию пользователя.

- после захвата изображения экрана происходит его кодировка в H.264 кодек и потоковая отправка на конечное устройство

- на серверной части, процесс кодировки использует ресурсы центрального процессора, чем сильно нагружает его, если картинка на экране изменяется с высокой частотой кадров

- на клиентской части установлен Citrix Receiver, который занимается обратным действием, декодирует входящий поток, для чего также используются значительные ресурсы центрального процессора

Сколько пользователей можно разместить на сервере с поддержкой vGPU?

Вопрос масштабирования в виртуализации графических рабочих станций не имеет единственно правильного решения и требует предварительного тестирования, в ходе которого лучше всего привлекать реальных сотрудников, будущих пользователей. Они должны будут работать в своем обычном режиме, а в это время на сервере будут сниматься показания, вот основные 4 значения:

- нагрузка на CPU, — особенности работы того или иного САПР с центральным процессором, в нашем случае с vCPU. Обычно, AutoCAD, Catia, Solidworks, Siemens NX, Компас 3D работают только с одним ядром выделенного процессора, и это значит, что при масштабировании нужно выделять каждой ВМ два vCPU и это позволит достичь максимальной производительности на данном железе. Но есть и исключения, например, Catia v20 уже умеет работать в много поточном режиме, и тут уже совсем другие расчеты. Также нужно учитывать, что значительную нагрузку на CPU создают процессы захвата изображения, этим страдают и Citrix — процесс ctxgfx.exe , и VMware c процессом pcoip_server.exe

- нагрузка на ядро GPU, — во время того, как сотрудники будут эмулировать работу с моделями в САПР, через консоль гипервизора можно отследить, как нагружается ядро видеокарты и сделать предварительные выводы о максимально возможном количестве одновременно работающих сотрудников.

- использование видеопамяти, — это значение можно зафиксировать внутри сессии пользователя, используя специальные утилиты. Объем видеопамяти в картах Nvidia Grid K1 и K2 не очень большой и получив статистику по использованию, мы поймем, на какие равные доли ее делить между пользователями

- использование оперативной памяти RAM, — большинство САПР продуктов очень жадные до оперативной памяти. У сервера, понятное дело, есть ограничения по максимальному объему, которое нужно учитывать.

Узким местом почти всегда оказывается процессор CPU, и причин тому несколько. Возьмем для примера Catia, работающую с центральным процессором в одно поточном режиме. В качестве технологии выбираем Citrix vGPU K220Q + XenDesktop 7.5 HDX 3D PRO , сервер с двумя картами Nvidia Grid K2. В теории мы можем запустить 32 виртуальные машины, что на тестовом стенде и делаем. Получаем следующие результаты:

- запущенны 32 ВМ, к ним подключены через Citrix Receiver 32 тестовых пользователя, Catia не загружена, общая нагрузка на 2 x CPU сервера около 30%

- пользователи начинают в разнобой загружать модели, при этом в сессии один из vCPU загружен на 100%, второй vCPU загружен на 10-20% (работает ОС). Общая нагрузка на 2xCPU сервера возрастает до 80%

- модели загружены, состояние покоя, Общая нагрузка на 2xCPU сервера 40%

- пользователи начинают работать с моделями, первый vCPU скачкообразно нагружается до 60-100%, второй vCPU тоже скачкообразно нагружается до 40-80% (нагрузка из-за работы HDX 3D PRO, идет захват и передача изображения. Общая нагрузка на 2xCPU сервера около 70-80%

- в какой-то момент, пользователи начинают жаловаться, что производительность упала и начались подвисания, фризы, деградация производительности….

- удача, если на этапе тестирования удается получить подобные ошибки и выяснить из-за чего они возникли. По опыту могу сказать, что нагрузка на 2xCPU сервера растет не линейно и в условиях конкуренции ВМ за ядра существует предел. Выясняем где он и масштабируем систему.

Всем хочется разместить больше сотрудников на одном сервере, это критично, ведь из этого складывается и экономическое обоснование решения перед руководством. Но строить воздушные замки из предположений и догадок не стоит, поэтому проводите предварительные тесты и трезво оценивайте потенциал технологии в реалиях вашей инфраструктуры.

Таблица, цена за рабочее место

Я надеюсь, что данная таблица поможет тем, кто интересуется решениями на базе Nvidia GRID систематизировать информацию, которая поступает из разных источников и перемешивается в голове в кашу. Я свел в таблицу все существующие на сегодняшний день профессиональные программные технологии в сочетании с серверными конфигурациями. Я посчитал примерную стоимость одного рабочего места и указал аналог видеоадаптера, который получит пользователь, подключившийся к VDI или терминальному серверу.

|

Кол-во пользователей на сервер |

Технология доставки рабочего стола |

Технология проброса видеокарты |

Гипервизор |

Видеокарта в сервере |

Эквивалент по мощности |

Стоимость рабочего места |

|

до 80 |

Citrix Terminal |

Прямой проброс |

Citrix XenServer |

2 x Nvidia Grid K1 |

Nvidia 410 |

475 $ |

|

до 40 |

Citrix Terminal |

Прямой проброс |

Citrix XenServer |

2 x Nvidia Grid K2 |

Nvidia K600 |

850 $ |

|

до 64 |

Citrix VDI |

Citrix vGPU (K100) |

Citrix XenServer |

2 x Nvidia Grid K1 |

Nvidia 410 |

537 $ |

|

до 32 |

Citrix VDI |

Citrix vGPU (K140Q) |

Citrix XenServer |

2 x Nvidia Grid K1 |

Nvidia K600 |

850 $ |

|

до 32 |

Citrix VDI |

Citrix vGPU (K220Q) |

Citrix XenServer |

2 x Nvidia Grid K2 |

Nvidia K600 |

1000$ |

|

до 16 |

Citrix VDI |

Citrix vGPU (K240Q) |

Citrix XenServer |

2 x Nvidia Grid K2 |

Nvidia K2000 |

1.812 $ |

|

до 8 |

Citrix VDI |

Citrix vGPU (K260Q) |

Citrix XenServer |

2 x Nvidia Grid K2 |

Nvidia K4000 |

3.350 $ |

|

до 8 |

Citrix VDI |

Прямой проброс |

Citrix XenServer |

2 x Nvidia Grid K1 |

Nvidia K600 |

2.725 $ |

|

до 8 |

VMware VDI |

Прямой проброс |

VMware ESXi |

2 x Nvidia Grid K1 |

Nvidia K600 |

2.850 $ |

|

до 4 |

Citrix VDI |

Прямой проброс |

Citrix XenServer |

2 x Nvidia Grid K2 |

Nvidia K5000 |

6.475 $ |

|

до 4 |

VMware VDI |

Прямой проброс |

VMware ESXi |

2 x Nvidia Grid K2 |

Nvidia K5000 |

6.600 $ |

!!Внимательно!!

Еще можно написать осторожно мошенники, обманщики, маркетологи ))

- Левый столбец в таблице полностью теоретически, за исключением минимальных значений, например 4 пользователя на сервере. На самом деле 32-80 пользователей на сервере одновременно работать не смогут, это фантастика, чисто теоретическое значение. Если вам кто-то скажет обратное можете смело отправлять такого человека в сад, он теоретик, продает черные ящики из «Что?Где?Когда?»

- Эквиваленты, не принимайте как факт, все очень примерно. Все зависит от того как работает та или иная технология проброса. Читайте в разделе о технологиях.

- В сервер могут быть установлены разные карты К1+К2, тогда получится еще одно сочетание, которое я не учитывал, чтобы таблица не разрослась в два раза

- Стоимость рабочего места считалась так, «Стоимость сервера с картами» + «Стоимость лицензий VDI или Терминал» делим на максимальное кол-во пользователей

Ожидается скоро

Ожидается скоро

Скажем прямо, технология виртуализации графических рабочих станций не самая доступная с точки зрения финансов. Найти в бюджете выделенном на ИТ сумму даже на самый минимальный по стоимости проект с Nvidia GRID может оказаться непосильной задачей. Скорее всего в таком бюджете нет денег и на лицензии… Для этого случая есть вариант на базе все того же Citrix XenDesktop, который после испытаний локально можно вынести на удаленную площадку (подальше от проверок, если вы понимаете о чем я)

Уже давно Citrix умеет использовать одну видеокарту для нескольких сессий внутри терминального сервера. В текущей версии Citrix XenDesktop 7.6 доступ к такой сессии осуществляется по современному протоколу HDX 3D с использование H.254 кодека. Чтобы настроить систему в минимальном исполнении вам потребуется:

- компьютер с видеокартой (не обязательно Nvidia GRID). Это может быть существующий ПК, мощность которого позволит работать на нем нескольким пользователям. Например, процессор i7, объем оперативной памяти 16Gb, видеоадаптер с 2Gb видеопамяти, SSD диск — такая конфигурация позволит посадить 4-6 человек на работу в AutoCAD 2015

- таких компьютеров может быть несколько, Citrix XenDesktop будет равномерно распределять по ним пользовательские сессии

- На данный ПК должен устанавливаться Windows server 2008 или 2012. А уже в операционную систему должен устанавливаться драйвер видеокарты.

- для управляющей части Citrix XenDesktop требуется виртуальная машина или отдельный физический сервер\ПК с 8Gb оперативной памяти

Такая конфигурация позволяет работать в САПР приложениях, которые запускаются в терминальном режиме. Плотность пользователей зависит от проектов, которые открываются пользователями. Если на терминальном сервере заканчивается один из ресурсов, то тормозить начинает у всех пользователей, поэтому нужно следить за активностью сотрудников и не допускать подобных вещей.

Наша компания оказывает платную помощь по настройке вышеописанных «демо» стендов на существующем оборудовании, связывайтесь через контакты.

На видео ниже пример удаленной работы с AutoCAD c использованием технологии Nvidia GRID и без нее.

В этой статье мы постараемся рассмотреть все аспекты проектов с применением технологий Nvidia GRID.

Если начать сначала, то стоит поговорить о рабочих станциях и причинах перехода на VDI и Терминальный доступ. Здесь перед ИТ стоят задачи централизации данных и мощностей в ЦОД, внедрения простых и эффективных инструментов управления, менеджмент лицензий, строгий контроль над возможностями пользователей и, как следствие, усиление безопасности. Комплексным решением для этих задач является перевод пользователей на работу в терминальных сессиях или VDI, чем и пользуются компании по всему миру. Но есть категории пользователей, для которых такой вариант неприемлем из-за того, что их программное обеспечение просто не работает должным образом в обычной терминальной сессии.

- Проектировщики всех мастей, которые занимаются созданием проектов в САПР, CAD программах. Причем это могут быть любые проекты, от шкафа-купе до подводной лодки. Для быстрой отрисовки динамичного изображения используются ресурсы видеоадаптера, основные характеристики — это количество ядер GPU и объем видеопамяти.

- Дизайнеры, работающие с популярными программами от Adobe или узкопрофильными специализированными также вынуждены устанавливать в свои ПК видеокарты.

- Инженеры, которые сами не проектируют, но открыть и посмотреть готовый проект им необходимо.

- Обычные пользователи. Дело в том, что большинство современных операционных система и офисных программ используют ресурсы видеоадаптера для отображения контента. Например, Windows Aero делает окна в Windows прозрачными, перемещение объектов плавными, переключение между вкладками красивыми. Такие программы, как MS Office 2013, Adobe Reader, современные браузеры используют видеоадаптер для ускорения работы и освобождения ресурсов центрального процессора.

Если убеждать кого-то в том, что тяжелые САПР не работают в VDI сессии без проброшенной видеокарты нет необходимости, то проблемы, которые испытывают обычные офисные пользователи не так очевидны. Для демонстрации записаны два видео, показывающие удаленную (через интернет) работу в IE 11 и MS Excel 2013 в сессии VDI в первом случае без видеокарты, а во втором с vGPU Nvidia GRID. Оба теста проводились на одном и том же стенде VMware Horizon View 6.1.1

Сразу оговорюсь, что результат не идеальный и есть куда стремиться.

Без Nvidia GRID

C vGPU Nvidia GRID

Как правило, современный терминальный сервер – это виртуальная машина, в которой есть виртуальная видеокарта, эмулирующая работу видеочипа, но использующая ресурсы центрального процессора. Естественно, такая видеокарта не может обеспечить необходимого быстродействия в программах и интерфейсах ОС, а наоборот замедляет их работу, т.к. CPU нужно в разы больше времени для обработки изображения чем GPU. Именно поэтому во всех руководствах рекомендуют отключать поддержку видеокарты в виртуальных машинах, использующихся для терминального доступа.

Какие проблемы можно решить виртуализацией графических рабочих станций?

Проект виртуализации графики, если его в лоб сравнивать с покупкой физических рабочих станций никогда не будет выгоднее. Это факт. Но есть ряд задач, ради выполнения которых организации готовы переплачивать:

- удаленный доступ, — если необходимо предоставить сотруднику простой удаленный доступ к проекту, который хранится в центральном офисе или ЦОД, то альтернативы, пожалуй, нет. Специалисты по САПР — это очень ценные кадры, штучный товар, который часто сложно найти на месте, их приходится искать в другом городе. Чтобы не передавать лицензию на ПО и сам проект целиком удаленному сотруднику, и не устраивать ему переезд, снимать жилье и т.д. теперь есть возможность организовать полноценный удаленный доступ.

- специфика работы, — установка полноценных рабочих станций невозможна (нежелательна) на некоторых производствах. У таких предприятий раньше был только один способ организации рабочего места, в серверной ставилась рабочая станция с платой захвата производства Teradici, изображение, клавиатура, мышь предавались на тонкий клиент на рабочем месте по сети LAN, а на далекие расстояния по FC. Технология Nvidia GRID совместно с Citrix или VMware позволяют снизить стоимость рабочего места на таких спец объектах.

- безопасность, — если рабочее место сотрудника будет состоять из тонкого клиента и мониторов, то можно будет гарантировать, что утечки данных проекта не произойдет. Максимум, что сможет сделать злоумышленник — это фотографировать экран.

- управление лицензиями, — лицензии САПР могут стоить миллион рублей и больше, нецелесообразно устанавливать их локально на какой-то один компьютер, где скорее всего постоянно работает какой-то сотрудник (это его рабочее место). Если же установить этот САПР на виртуальные машины с поддержкой графики в ЦОД и дать к ним удаленный доступ, то в условиях ограниченного количества лицензий ими смогут воспользоваться бОльшее количество специалистов.

- мощная графическая станция каждому, — даже если мы делим видеокарту Nvidia Grid K2, которая соответствует по мощности K5000, то все равно в условиях малой конкуренции каждому пользователю доступна вся мощность графического ядра. Это специфика работы технологии Nvidia vGPU. Если вашим пользователям требуется мощность, но бюджета для покупки каждому рабочей станции с мощной видеокартой нет, то вам стоит задуматься над альтернативой — виртуализацией графических рабочих станций.

- близость к данным, — крупные проекты хранятся в PLM системах, каждый сотрудник работает над своим узлом для чего выгружает его из общего хранилища и, поработав, возвращает обратно. Здесь критична ширина канала между общим PLM хранилищем и рабочей станцией, чем быстрее канал, тем меньше времени будет тратить конструктор на загрузку-выгрузку. Бывает даже, что на территории одного предприятия каналы не позволяют работать быстро, приходится терять драгоценное время. Про работу над одним проектом из разных городов и говорить не приходится. Опять же, проблема решается виртуализацией графических рабочих станций.

- продолжение проекта VDI, — рвньше, в рамках проекта VDI можно было успешно виртуализировать только ПК, на которых выполняются простые офисные задачи. Графические станции виртуализировать было невозможно. С технологиями от Nvidia, Citrix и VMware, появился шанс закончить проект.

- учебные классы, — учебный класс, это всегда много компьютеров на небольшой площади. Всегда хочется, убрать системные блоки с учебных мест и оставить на нем моноблок или монитор с тонким клиентом. Это значительно упростит администрирование и подготовку к занятиям, создаст тишину и простор в классе. Эффективное использование лицензий. Например, если учебных классов несколько, а лицензий САПР куплено только на один из них и установлены они локально. И в этом классе, проходят другие занятия и эти лицензии простаивают. Постоянные конфликты интересов разных преподавателей.

- жара на рабочем месте, — стандартный офис, особенно в бизнес центре, не рассчитан на то, что в помещении будут работать на рабочих станциях мощностью 1000Вт. Кондиционеры просто не справляются с тем теплом, которое выделяют компьютеры конструкторов, температура неуклонно растет, производительность труда падает, работать становится крайне сложно. В такой ситуации нужно убирать рабочие станции в серверную или совместить это с виртуализацией рабочих станций.

обновлено апрель 2020